In collaborazione con: BSD 2024

Durante lo scorso anno, sono tanti i casino online ad avere ottenuto la licenza di gioco AAMS/ADM. Grazie all’aumento della offerta di gioco, abbiamo avuto in parallela un aumento delle offerte bonus di benvenuto, con o senza deposito.

Queste offerte di benvenuto sono delle offerte speciali riservate ai nuovi giocatori di un casino, le quali possono essere usate per giochi del casino o scommesse sportive, a seconda dei termini e delle condizioni della promozione stessa.

Per questo motivo abbiamo selezionato i 10 migliori casino con bonus di benvenuto senza deposito. In questo modo non dovrai perdere tempo passando da un casino all’altro, in cerca dell’offerta di benvenuto perfetta per te.

La lista di promozioni di casino senza deposito che vedi qua sotto è stata aggiornata a Febbraio 2024. Ovviamente non abbiamo preso in considerazione solo l’importo bonus, ma anche la trasparenza delle promozioni e le loro condizioni favorevoli.Migliori casino Online con Bonus Benvenuto Senza Deposito • AdmiralBet Casino: 200% Fino 1000€ + 100€ Gratis + 100 Giri Gratis ? • LeoVegas Casino: 100% Fino 1500€ + 250 Giri Gratis ? • Starvegas Casino: 100% Fino 1000€ + 60 Free Spins ? • William Hill Casino: 100% Fino 1000€ + 400 Spins ? • Gioco Digitale Casino: 100% Fino 500€ + 300 Spins ? • Eurobet Casino: 100% Fino 1000€ + 10€ Gratis + 500 Spins ? • Starcasino: Fino 2000€ Cashback + 50 Spins ? • Bwin Casino: 100% Fino 200€ + 50 Spins ? • Netbet Casino: 100% Fino 600€ + 200 Spins ? • 888 Casino: 125% Fino 500€ + 20€ Gratis ?1. AdmiralBet casino: 200% Fino 1000€ + 100€ Gratis + 100 Giri GratisAdmiralBet è arrivato come un fulmine a ciel sereno nella nostra lista di casino con miglior bonus di benvenuto senza deposito in Italia. In qualità di uno degli ultimi casino online che abbiamo provato, è riuscito a portare una ventata di novità, grazie a un bonus di benvenuto solido e alla sua ottima reputazione maturata a livello internazionale.

Se stai cercando un bonus di benvenuto per divertirti su un nuovo casino online, AdmiralBet offre un match bonus del 200% fino 1000€, insieme a due bonus gratis. Uno di fun bonus di 100€ gratis e l’altro da 100 giri gratis.

Questo bonus vale solo per le slot, ma ci sono numerose promozioni riservate a chi gioca alle scommesse sportive e casino dal vivo, ma nessuna di queste è senza deposito. Inoltre, questo casino AAMS è semplice da usare, facile da navigare e adatto anche ai neofiti del gioco d’azzardo.Ho inoltre trovato i termini e le condizioni di questo bonus facili da leggere, anche per chi non è pratico. Non ci sono cose a cui dovresti prestare attenzione, in quanto tutto è spiegato in modo chiaro e dettagliato. Ecco che voto hanno dato alcuni siti di recensione ad AdmiralBet:

Pagina

Punteggio

Verifica

Bookmakers AAMS 9.8 Febbraio 2024

Trustpilot 9.2 Febbraio 2024

Casino Sicuri 9.5 Febbraio 2024

▶ Ricevi il Bonus di Admiral Bet Casino

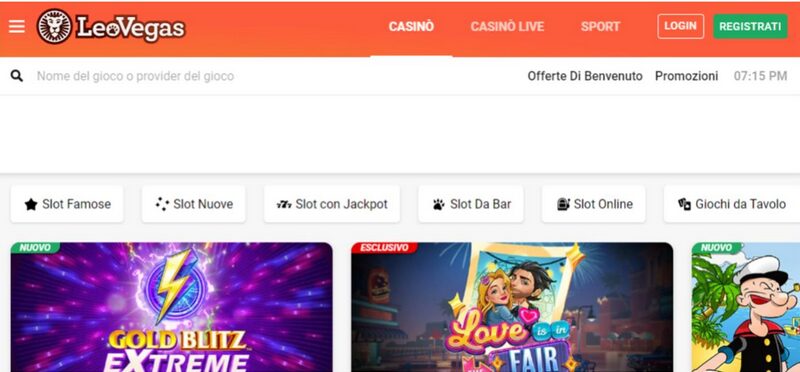

2. LeoVegas casino: 100% Fino 1500€ + 250 Giri Gratis

LeoVegas è un casino giunto alla ribalta grazie alla sua versione mobile del casino. Infatti, in Italia, è conosciuto come il casino per telefono per eccellenza. No, non dovrai per forza giocarci da telefono per ricevere la sua esclusiva promozione di benvenuto!

Infatti, sia ai giocatori da PC che a quelli da smartphone, LeoVegas casino offre un bonus perfetto e adatto a tutte le tasche. I nuovi iscritti potranno ricevere un bonus del 100% fino a 1500€ sul loro deposito, insieme a 250 giri gratis per giocare alle slot machine più belle del sito.

I termini relativi al contratto di gioco, che dovrai accettare prima di ricevere il tuo bonus, non sono confusionari, pertanto non ci saranno inghippi o confusioni per chi decide di aprire un conto gioco su questo sito.Per questo motivo penso che una seconda posizione è più che meritata per LeoVegas. Andiamo però a vedere che voto hanno dato a questo sito alcuni siti che operano nella nostra nicchia:

Pagina

Punteggio

Verifica

Bookmakers AAMS 9.6 Febbraio 2024

Trustpilot 9.5 Febbraio 2024

Casino Sicuri 9.3 Febbraio 2024

▶ Ricevi il Bonus di LeoVegas Casino

3. Starvegas casino: 100% Fino 1000€ + 60 Free Spins

StarVegas casino non è solo uno dei casino più conosciuti in Italia, ma anche uno dei casino con il miglior bonus di benvenuto sul mercato per i nuovi giocatori. Si tratta di uno dei primissimi brand in Italia ad avere lanciato il casino dal vivo, con una sezione ricchissima di titoli firmati Evolution Gaming.

Il bonus per i nuovi giocatori di StarVegas casino è del 100% fino 1000€ sul primo deposito, insieme a 60 giri gratis che non richiedono alcun deposito. Di mio, posso dirti che è uno dei siti su cui la verifica del mio conto gioco è avvenuta con la maggior rapidità!

Una nota di merito va anche ai termini e condizioni delle offerte bonus, i quali vengono evidenziati in chiaro e con tutte le spiegazioni al posto giusto. Inoltre, con cadenza quasi settimanale, vengono lanciate delle promozioni per i giocatori esistenti di questo casino AAMS.Che altro dire su StarVegas? Beh, che avrai una lista ricchissima di giochi Greentube a cui potrai giocare con questo fantastico casino online. Ecco il voto di StarVegas dato dai più celebri siti di recensione di casino online:

Pagina

Punteggio

Verifica

Bookmakers AAMS 9.0 Febbraio 2024

Trustpilot 9.1 Febbraio 2024

Casino Sicuri 8.9 Febbraio 2024

▶ Ricevi il Bonus di Starvegas Casino

4. William Hill casino: 100% Fino 1000€ + 400 Spins

William Hill è un nome notissimo agli amanti delle scommesse di tutto il mondo, ma la fama di questo bookmaker è meritata anche per quanto riguarda la sua offerta di casino. Ci sono un paio di bonus su William Hill casino, anche di buon importo, che dovresti seriamente prendere in considerazione.

Parliamo di un pacchetto bonus del 100% fino a 1000€ sul primo deposito da giocare sulle slot machine del sito. Questo bonus ha un requisito di puntata pari a 40X, quindi in linea coi bonus dati dalla maggior parte dei casino. Ci sono poi 400 spins gratis che potrai ricevere registrandoti.

William Hill casino fa parte di un gruppo in circolazione dal 1964, pertanto è un nome conosciuto e del quale dovresti poterti fidare. Analizzando i termini e le condizioni delle sue offerte, non ho trovato zone d’ombra di alcun tipo.Infatti, le scadenze dei bonus, i requisiti di puntata, e l’accesso all’assistenza clienti non sono nascosti o scritti in piccolo come capita su altri siti di casino. Ecco che voto danno a William Hill casino gli altri siti:

Pagina

Punteggio

Verifica

Bookmakers AAMS 8.8 Febbraio 2024

Trustpilot 8.9 Febbraio 2024

Casino Sicuri 9.1 Febbraio 2024

> Ricevi il Bonus di William Hill Casino

5. Gioco Digitale casino: 100% Fino 500€ + 300 Spins

La sicurezza è uno dei fattori fondamentali quando si parla di casino online. Per questo motivo, su GD casino, usano i migliori protocolli di trasferimento dati, offrendoti una esperienza di gioco sicura, dalla riscossione del bonus al gioco vero e proprio.

Le promozioni di Gioco Digitale casino sono probabilmente “il bello” di questo sito. Il motivo? Ce ne sono tante e sono dedicate a tutte le sezioni del sito. Parlando della promozione principale, abbiamo un match bonus del 100% sul primo deposito fino a 500€ più 300 spins da giocare gratis.

Analizzando i termini e condizioni di questa promo, è saltato fuori che il requisito di scommessa è pari a 35X l’importo del bonus, ovvero 5 volte in meno rispetto a quello di William Hill. Un valore sotto la media e che reputo estremamente buono!Un buon voto va anche alla trasparenza di Gioco Digitale casino. Questo sito non vuole nascondere nulla con mezzi termini o condizioni nascoste, anzi, cerca di fare tutto alla luce del sole. Sarà per il lungo tempo sul mercato, oppure per semplice lealtà verso i giocatori Italiani. Ecco i voti dei nostri competitori:

Pagina

Punteggio

Verifica

Bookmakers AAMS 8.8 Febbraio 2024

Trustpilot 8.5 Febbraio 2024

Casino Sicuri 8.4 Febbraio 2024

> Ricevi il Bonus di GD Casino

6. Eurobet Casino: 100% Fino 1000€ + 10€ Gratis + 500 Spins

Eurobet casino si distingue nel panorama dei casino online italiani con un’offerta di benvenuto tra le più generose del mercato. Con un bonus del 100% fino a 1000€, oltre a un extra di 10€ gratis e ben 500 giri gratuiti, è una scelta top per chi cerca varietà e qualità.

Questo casinò, noto per la sua affidabilità e per una gamma di giochi entusiasmante, offre esperienze di gioco immersive, compresa una vasta selezione di slot machine. La registrazione è veloce e i termini dei bonus sono chiaramente spiegati, rendendo Eurobet un’opzione sicura e trasparente.Durante la mia prova di questo casinò, ho trovato un sito semplice da navigare, in cui l’esperienza dell’utente viene messa al primo posto. Inoltre, in ogni momento, il team di Eurobet è pronto ad aiutare e fornire supporto.Che altro dire? L’opzione di ricaricare il conto tramite punto PVR è ottima per chi è allergico alle transazioni online, facendo di questo sito una soluzione a tutto tondo. Curioso di sapere il voto di Eurobet sui maggiori siti di recensione casino?

Pagina

Punteggio

Verifica

Bookmakers AAMS 8.3 Febbraio 2024

Trustpilot 8.4 Febbraio 2024

Casino Sicuri 8.8 Febbraio 2024

> Ricevi il Bonus di Eurobet Casino

7. Starcasino: Fino a 2000€ Cashback + 50 Spins

Starcasino va oltre il tradizionale bonus di benvenuto, offrendo fino a 2000€ di cashback e 50 giri totalmente gratis come bonus di benvenuto, attirando sia giocatori nuovi che esperti.

Questo casinò è famoso per la sua eccellente assistenza clienti e un’interfaccia utente intuitiva. Con una vasta selezione di giochi da casinò e slot, Starcasino garantisce un’esperienza di gioco di alto livello. Il processo di verifica dell’account è rapido e i termini dei bonus sono esposti in modo trasparente.Le promozioni che Starcasino offre non sono ovviamente tutte qua. Ce ne sono parecchie, sia per slot machine che per sport, insieme a cashback settimanali e tornei sui giochi di slot più emozionanti.Insomma, oltre a una offerta di benvenuto senza deposito competitiva e molto apprezzata dai giocatori Italiani, Starcasino ha tanto da offrire. Vediamo cosa ne pensano di Starcasino i siti di recensione Italiani:

Pagina

Punteggio

Verifica

Bookmakers AAMS 8.9 Febbraio 2024

Trustpilot 8.5 Febbraio 2024

Casino Sicuri 9.5 Febbraio 2024

> Ricevi il Bonus di Starcasino

8. Bwin Casino: 100% Fino a 200€ + 50 Spins

Nonostante i numerosi anni spesi nel mercato, Bwin casino offre un’accattivante offerta di benvenuto con un bonus del 100% fino a 200€ e, per coloro che cercano qualcosa di più goloso, 50 giri gratuiti per le slot machine più belle.

Conosciuto per la sua piattaforma di scommesse sportive, Bwin si distingue anche nel mondo dei casinò online con una vasta selezione di giochi e slot. La registrazione è semplice e i termini delle offerte bonus sono facilmente accessibili e comprensibili, assicurando una grande trasparenza.Da qualche tempo il sito ha rifatto il suo layout, diventando più appetibile per i giocatori in cerca di una interfaccia di gioco moderna e perfettamente compatibile col telefono o tablet. Di mio, posso dire che Bwin ci ha preso in pieno questa volta.Che altro dire? Un bonus di benvenuto senza deposito un po bassino rispetto gli altri in questa lista, ma sicuramente molto valido, grazie al nome “forte” che accompagna questa piattaforma di gioco. Ecco il voto di Bwin nei siti di recensione più celebri:

Pagina

Punteggio

Verifica

Bookmakers AAMS 9.1 Febbraio 2024

Trustpilot 9.2 Febbraio 2024

Casino Sicuri 7.9 Febbraio 2024

> Ricevi il Bonus di Bwin Casino

9. Netbet Casino: 100% Fino a 600€ + 200 Spins

Netbet casino da il benvenuto ai nuovi giocatori con un bonus di benvenuto del 100% fino a 600€. Questo, ovviamente, per quanto riguarda il bonus sul deposito, detto anche match bonus. Esiste anche un bonus di benvenuto senza deposito, pari a 200 giri gratuiti.

Questo casinò è rinomato per la sua vasta gamma di giochi e per la sua piattaforma user-friendly, oltre ad avere un programma di affiliazione per gioco d’azzardo migliori del mercato. A memoria, credo sia il primo o secondo casinò con licenza AAMS che ho provato in vita mia, giusto per farti capire da quanto tempo è in circolazione!Con un’interfaccia pulita e una navigazione intuitiva, Netbet rende l’esperienza di gioco piacevole e senza stress. La verifica dell’account è rapida e i termini delle promozioni sono chiari e ben spiegati.Ricapitolando, termini trasparenti, interfaccia pulita e una buona promozione di benvenuto senza deposito. Cosa ne penseranno gli altri siti di recensione di Netbet casino? Andiamo a scoprirlo:

Pagina

Punteggio

Verifica

Bookmakers AAMS 9.1 Febbraio 2024

Trustpilot 9.0 Febbraio 2024

Casino Sicuri 8.3 Febbraio 2024

> Ricevi il Bonus di Netbet Casino

10. 888 Casino: 125% Fino a 500€ + 20€ Gratis

Se giochi da tempo ai casinò online, conoscerai sicuramente questo sito. 888 Casino supera le aspettative con un’offerta di benvenuto del 125% fino a 500€, più un bonus aggiuntivo di 20€ gratis. Da tempo ha abbandonato l’offerta per cui è diventato celebre, ovvero quella di 88 giri gratis, ma questa è altrettanto buona.

Questo casinò è conosciuto a livello internazionale per la sua affidabilità e per la sua straordinaria selezione di giochi. L’iscrizione è veloce e i bonus hanno termini chiari e trasparenti. 888 Casino si impegna a fornire un’esperienza di gioco sicura e responsabile, con un eccellente servizio clienti.La cosa che mi ha colpito di questo bonus è la possibilità di giocarlo in numerose slot machine, non la classica lista di 7 o 8 come succede nella maggior parte dei casinò. Inoltre, questo bonus gratis, può essere giocato anche sulla versione elettronica di roulette e blackjack.Avrai capito che 888 casinò mi ha colpito positivamente, ma sarà un caso isolato? Vediamo cosa ne pensano gli altri siti di recensione in Italia:

Pagina

Punteggio

Verifica

Bookmakers AAMS 8.5 Febbraio 2024

Trustpilot 8.5 Febbraio 2024

Casino Sicuri 8.7 Febbraio 2024

>Ricevi il Bonus di 888 Casino

Come Valutiamo i Migliori Bonus di Benvenuto Senza Deposito?Per valutare i migliori bonus di benvenuto senza deposito in Italia, ci siamo soffermati su alcuni punti, tutti direttamente o indirettamente inerenti alle promozioni di benvenuto. Per essere trasparenti nei tuoi confronti, li abbiamo elencati di seguito:

1. Requisito di Scommessa del Bonus: Un aspetto cruciale nella valutazione dei bonus di benvenuto senza deposito dei casinò è il requisito di scommessa. Questo indica quante volte il giocatore deve puntare l’importo del bonus prima di poter prelevare le vincite. Un requisito di scommessa più basso è generalmente più vantaggioso per il giocatore, poiché rende più facile incassare il bonus. Esaminiamo attentamente questi requisiti per assicurarci che siano equi e realistici, offrendo ai giocatori una valutazione onesta e accurata del bonus.

2. Ammontare del Bonus: L’ammontare del bonus senza deposito

ovviamente un fattore importante. Un bonus elevato può sembrare attraente, ma deve essere bilanciato con altri fattori come i requisiti di scommessa e le limitazioni di gioco. Analizziamo l’entità dei bonus offerti per determinare il loro valore reale per i giocatori, considerando anche come questi si confrontano con le offerte di altri casinò online.

3. Elasticità dei Termini e Condizioni: L’elasticità dei termini e condizioni di un bonus è un altro aspetto fondamentale. Valutiamo quanto sono flessibili questi termini, come la scadenza del bonus e la varietà di giochi su cui il bonus può essere utilizzato. Un bonus che è limitato a pochi giochi o che ha una scadenza stretta può essere meno attraente. Cerchiamo bonus che offrano ai giocatori la massima flessibilità e libertà di scelta, migliorando così l’esperienza di gioco complessiva.

Perché AdmiralBet ha il Miglior Bonus di Benvenuto Senza Deposito? I 10 casinò online con bonus di benvenuto senza deposito, si sono tenuti testa, eppure AdmiralBet casinò è stato votato come il numero 1. Come mai abbiamo preso questa scelta?

Sinceramente, ci abbiamo pensato a lungo, ma poi, poco dopo le ore 20:00, ci siamo decisi: AdmiralBet casinò con il suo bonus del 200% fino a 1000€, con 100€ gratis e 100 giri gratis, è l’offerta migliore per i nuovi giocatori Italiani.

Questo sito non nasconde assolutamente nulla: tutto è fatto in modo trasparente e il gruppo alle spalle di questa piattaforma è Admiral, uno dei nomi più celebri nel panorama del gioco d’azzardo in Europa.Insomma, la combinazione di affidabilità, giocabilità e ammontare del bonus, ha fatto si che AdmiralBet sia la nostra prima scelta tra i bonus benvenuto senza depositare in Italia.Perché Giocare nei Casino Italiani con i Migliori Welcome Bonus Senza Deposito?Dovreste giocare nei casino che offrono i migliori bonus di casinò, gratis e non, per una semplice ragione: facciamo tutte le doverose ricerche al posto tuo, senza prendere alcun bonus alla leggera.Per ogni casinò online che testiamo, valutiamo che non ci siano problemi e rischi per la sicurezza e che tutto sia a posto per garantirti la migliore esperienza di gioco. Inoltre testiamo un bonus dalla A alla Z.

Il bonus può essere effettivamente sbloccato? Il requisito di scommessa è quello indicato nei termini e condizioni? Quali giochi sono giocabili per sbloccare questo bonus? Cerchiamo le risposte a tutto questo.

Inoltre leggiamo tutto, anche quello scritto in piccolo in fondo alle pagine. Per questo ci assicuriamo che tutti i casino online con bonus di benvenuto senza deposito nella nostra lista siano il meglio del meglio.Differenza tra Bonus di Benvenuto e Bonus Senza DepositoUn bonus di benvenuto, comunemente offerto da numerosi operatori del settore dei casinò, consiste in una promozione che permette ai giocatori di ottenere un bonus che corrisponde a una percentuale del loro primo deposito sul sito.Questo tipo di bonus è soggetto a certi requisiti di puntata e ad altre condizioni, come un termine massimo entro cui utilizzarlo e limiti di età conformi alla normativa Italiana sul gioco d’azzardo.

Al contrario, il bonus senza deposito, pur presentando alcune similitudini con il bonus di benvenuto classico, si distingue per un fattore fondamentale: non richiede alcun versamento iniziale da parte del giocatore per essere attivato.

Le modalità di riscatto di questo bonus possono variare: In alcuni casi, è sufficiente registrarsi per riceverlo, mentre in altri può essere necessaria la verifica dell’identità del giocatore. Per esperienza, ti dico che quasi sempre è richiesta questa conferma di identità.Come nel caso dei bonus calcolati su una percentuale del deposito, anche il bonus senza deposito è vincolato da requisiti di puntata, noti anche come wagering o rollover. Pertanto, dovrai per forza depositare denaro reale per poterlo convertire. Questo è quello che i casinò non ti dicono mai, tu però tienilo a mente per evitare brutte sorprese.Posso Ritirare le Vincite Ottenute Tramite un Bonus Senza Deposito?

La questione se sia possibile o meno incassare le vincite accumulate attraverso i bonus senza deposito è comune tra i giocatori. La risposta è affermativa: è fattibile, a condizione che vengano soddisfatti i requisiti di puntata specifici della piattaforma, come abbiamo spiegato nella sezione precedente.

Una volta che il giocatore ha completato questi requisiti di rollover, l’importo vinto viene trasferito dal saldo bonus a quello effettivamente prelevabile, permettendo al giocatore, se lo desidera, di trasferire i fondi sul proprio conto bancario.Ricorda che, come succede per ogni prelievo, potrebbe anche esserti richiesta della documentazione KYC per poter procedere con il prelievo, in linea con la legge Italiana che regola il tema di riciclo di denaro.Come Ricevere un Bonus di Benvenuto Senza Deposito?Ricevere uno di questi bonus non è difficile. In primo luogo, dovrai seguire questi passi. Prima di farlo, assicurati di essere maggiorenne e di avere una carta d’identità o patente di guida a portata di mano, in quanto ti servirà per verificare il conto gioco.1. Accedi a uno dei casinò online che ti abbiamo suggerito.2. Clicca sul tasto “Registrati” in alto a destra nella pagina del casinò.3. Inserisci i tuoi dati personali, oppure seleziona la registrazione con SPID.4. Aggiungi la tua e-mail e numero di telefono per la verifica.5. Conferma il tuo conto, cliccando nel link inviato alla tua e-mail.6. Vai alla sezione dedicata alle promozioni del casino.7. Seleziona il tipo di bonus desiderato: match bonus o senza deposito.8. Segui le indicazioni del casinò e inizia a giocare.Domande dei Giocatori sui Bonus Senza Deposito di BenvenutoEcco le domande più comuni fatte dagli utenti sui bonus senza deposito di benvenuto nei casinò online AAMS.Quali sono le varietà comuni di bonus di benvenuto senza deposito?Generalmente, i bonus di benvenuto senza deposito più comuni includono denaro bonus gratuito e giri gratuiti per i nuovi giocatori.In cosa consiste il requisito di puntata per un bonus senza deposito?Il requisito di puntata determina il numero di volte che bisogna giocare l’importo ricevuto come bonus prima di poter ritirare eventuali vincite. Per esempio, un requisito di puntata di 35X, significa che il bonus deve essere giocato 35 volte con denaro reale.È possibile ottenere più bonus senza deposito nello stesso casinò?Questo è possibile solo nel caso in cui il casinò offra promozioni diverse, come ad esempio quelle settimanali. Queste sono promozioni piuttosto comuni.Qual è il procedimento per la verifica del conto in un casinò online?Per verificare il proprio conto gioco in un casinò, è necessario inviare una copia del documento d’identità al servizio clienti o caricarla dalla propria dashboard.I bonus di benvenuto senza deposito sono affidabili?Assolutamente sì, i bonus senza deposito offerti da casinò con licenza ADM, come AdmiralBet, sono regolamentati e affidabili.Qual è il miglior bonus di benvenuto senza deposito in Italia? Secondo le nostre ricerche, il miglior bonus di benvenuto senza deposito in Italia è quello offerto da AdmiralBet, pari a 200% fino 1000€ + 100€ gratis + 100 giri gratis.Vale la Pena di Giocare ai Casino coi Migliori Bonus di Benvenuto Senza Deposito?Arrivati alla fine di questo articolo, vale la pena o no giocare ai casinò che offrono questi bonus? Secondo me e il mio team, assolutamente si. Esistono numerosi casino online in Italia, ma solo una manciata di questi offrono un bonus di benvenuto competitivo.

L’obiettivo di questa pagina è proprio quello di farti capire quali sono i migliori bonus di benvenuto senza deposito che potrai ricevere oggi stesso. Qualora decidessi di giocare adesso o tra qualche giorno, ricorda sempre una cosa, gioca con testa.

Ci sono tanti rischi legati al gioco nei casinò online e solo giocando con testa non rischierai di cadere nella dipendenza. Se hai avuto una giornata no o non ti senti emotivamente a posto, lascia stare, salva questa pagina e torna a giocare in un secondo momento, perchè il benessere personale viene al primo posto.