I sessant’anni della scuola media. Storia dei cambiamenti avvenuti negli insegnamenti di matematica e scienze in un’ottica fusionista.

Giacinto Bosco (1905 – 1997)

La legge n. 1859 del 31 dicembre 1962 istituì la scuola media unica per tutti i preadolescenti italiani.

Dopo la pubblicazione dei programmi per la scuola elementare nel 1955, dominava un marcato ottimismo circa la definizione dell’assetto da dare alla scuola media, problema reso peraltro impellente dal dettato costituzionale sull’obbligo scolastico. Ci fu bisogno però di un ulteriore settennio di maturazione perché fosse varata la più importante legge del sistema scolastico italiano del dopoguerra, la legge 31 dicembre 1962, n. 1859, che istituisce e ordina la «nuova» Scuola Media:

Art.1. — Fini e durata della scuola

In attuazione dell’articolo 34 della Costituzione, l’istruzione obbligatoria successiva a quella elementare è impartita gratuitamente nella scuola media, che ha la durata di tre anni ed è scuola secondaria di primo grado. La scuola media concorre a promuovere la formazione dell’uomo e del cittadino secondo i princìpi sanciti dalla Costituzione e favorisce l’orientamento dei giovani ai fini della scelta dell’attività successiva.

Art. 2. — Piano di studi

Il piano di studi della scuola media comprende i seguenti insegnamenti obbligatori: religione (con la particolare disciplina di cui alla legge 5 giugno 1930, n. 824); italiano, storia ed educazione civica, geografia; matematica, osservazioni ed elementi di scienze naturali; lingua straniera; educazione artistica; educazione fisica.Sono inoltre obbligatorie nella prima classe le applicazioni tecniche e l’educazione musicale che diventano facoltative nelle classi successive.Nella seconda classe l’insegnamento dell’italiano viene integrato da elementari conoscenze di latino, che consentano di dare all’alunno una prima idea delle affinità e differenze fra le due lingue.Come materia autonoma, l’insegnamento del latino ha inizio in terza classe; tale materia è facoltativa.L’alunno che intenda seguire insegnamenti facoltativi può sceglierne uno o più all’inizio di ogni anno scolastico.Per assicurare con la partecipazione attiva di tutti gli insegnanti la necessaria unità di insegnamento il Consiglio di Classe si riunisce almeno una volta al mese[1].

I programmi, gli orari e le prove di esame furono stabiliti con D. M. del 24.4.1963 e pubblicati nel supplemento ordinario n. 1 della G.U. n.124 dell’11.5.1963.

La Matematica e le Osservazioni ed elementi di scienze naturali vi figurano come corsi distinti. La matematica ha 3 ore in ciascuna classe del triennio, e prevede agli esami di licenza prove scritte e orali; alle Osservazioni ed elementi di scienze sono assegnate 2 ore in prima e in seconda classe e 3 ore nella terza, un voto per l’orale e uno per la pratica.

È successivamente che avviene il “pasticcio”: è il D.P.R. 15.11.1963 n. 2063 che abbina gli insegnamenti istituendo una cattedra di 16 ore d’insegnamento settimanali per ciascun corso.

Non fu una soluzione inventata dalla sera alla mattina, ma v’era stato un lungo dibattito e un’esperienza di sperimentazione avviata già dal 1957 in molte scuole[2]. Se da una parte, però, la scelta fu determinata anche da motivi organizzativi e pratici (tra l’altro anche la previsione della necessità, di lì a pochi anni, di un numero elevato di docenti), dall’altra si era formato il convincimento, condiviso più dai politici e dai pedagogisti che dai matematici, che fosse necessario a tale livello di età non frantumare troppo gli insegnamenti. Si riconosceva, infatti, che uno dei vantaggi dell’antico ginnasio inferiore, che anche la scuola media di Bottai (1940) aveva ereditato, era costituito dall’insegnante di classe, il quale svolgendo l’intero gruppo letterario (italiano, latino, storia, geografia, a cui poi si era aggiunta l’educazione civica) “dava di fatto unità all’insegnamento, continuando in certo modo l’unicità di insegnante della scuola elementare, ed evitando nella delicata età della preadolescenza la molteplicità di metodi e di impostazione, inevitabilmente congiunta con la molteplicità di insegnanti. Da questo punto di vista… sembra molto opportuno l’abbinamento della matematica con le osservazioni ed elementi di scienze naturali, che tuttavia pare abbia sollevato difficoltà da parte di alcuni insegnanti di queste discipline”[3]

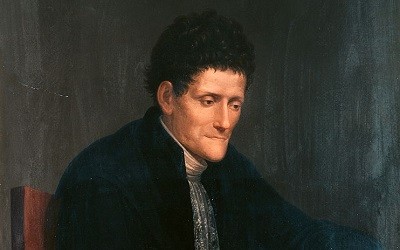

Tullio Viola (1904 – 1985)

Le difficoltà consistevano, è ovvio, nel dover insegnare cose che non si conoscevano e questo valeva sia per i laureati in matematica che per i laureati in scienze.

A farsi portavoce di tali difficoltà fu l’UMI, il cui ufficio di Presidenza espresse voto unanime contro l’abbinamento perché “non giova né alla serietà né alla efficacia dell’insegnamento ed è lesivo dei diritti degli insegnanti di ruolo di Matematica”. Ma anche la Mathesis, presidente Tullio Viola[4] (1904-1985, nella foto a lato), provvide ad inviare al Ministro un “Manifesto” con le firme di 637 docenti che giudicavano “l’abbinamento tra le due materie come fatalmente e gravemente dannoso anche dal solo punto di vista della formazione dei giovani allievi dagli 11 ai 14 anni”. Ad eccezione delle osservazioni sul disagio dei professori di matematica i quali, pur in presenza di un minor numero di classi affidate, sono costretti ad insegnare le scienze, le motivazioni addotte contro l’abbinamento appaiono, però, abbastanza ripetitive, basandosi sulla impreparazione dei docenti ad insegnare ugualmente bene la matematica e le scienze.

Giganteggia, invece, la figura di B. de Finetti che ovviamente è per l’abbinamento: lui è sempre e solo per la “fusione”.

Vorrebbe non solo non separare la persona (un esempio che fa anche, contrariamente a quel che tutti propongono, per il caso dell’insegnante di matematica e fisica) ma neppure le ore d’insegnamento (e così sarà in seguito). Espone e motiva la sua posizione in modo esauriente, ponendo a fondamento del suo ragionamento l’assioma: «Nessuna disciplina, avulsa dal contesto generale, giustifica la propria esistenza e la fatica imposta a chi deve apprenderla» e arriva finanche ad abbozzare un possibile futuro libro di testo organizzato a mo’ di dizionario enciclopedico.

La sua è un’idea nuova confacente a quel clima culturale, pedagogico e didattico che favorisce l’abbinamento.

È quel clima che si alimenta dell’opera di Emma Castelnuovo e di altre voci nuove. Ancor prima che l’abbinamento fosse sancito dal D.P.R. del mese di novembre, nella sua “Didattica della Matematica”, la cui prima edizione è del marzo 1963, con riferimento ai “continui ravvicinamenti” dei due corsi, la Castelnuovo scrive:

« Siamo certamente tutti d’accordo nel riconoscere che l’educazione scientifica deve avere per scopo di far passare da una visione fantasiosa, magica, sovrannaturale del mondo che ci circonda ad un’obiettiva consapevolezza e ad un sereno giudizio dei fenomeni naturali; deve essere, in breve, una continua ascesa nell’arte del saper guardare. Ora, mi sembra di poter distinguere in questa ascesa quattro grandi periodi ai quali dovrebbero corrispondere quattro tappe nel corso triennale:

I) L’osservazione dei passatempi preferiti dal bambino sui 10-11 anni ci offre l’opportunità di una scoperta pedagogica; è a quell’età che si acuisce nel bimbo la passione classificatoria: raccolta di figurine, di francobolli, di farfalle, ecc. Il collezionismo è — per usare una felice espressione della Montessori — il “momento sensibile” del periodo intorno ai 10 anni. È dunque proprio a questa età, nel primo anno della scuola media, che dobbiamo interessare i ragazzi alla classificazione degli animali e delle piante.[….] La costruzione di una classificazione ha per scopo di organizzare le idee, di dare un ordine alle forme, al Ci accorgiamo di essere in piena costruzione matematica: è lo stesso processo mentale infatti che ci conduce, ad esempio in geometria, alla classificazione delle famiglie dei poligoni[….] Il “saper guardare” porta dunque il ragazzo, spontaneamente, senza ausilio del numero, ma sorretto da un abito matematico, ad una costruzione astratta basata su osservazioni qualitative: il bambino, analizzando il concreto, coglie analogie e diversità, raggruppa cose simili, forma delle classi, costruisce, sintetizza. Si può, per nostra comodità e guida di pensiero, associare questo periodo al nome di Aristotele.

II) Ma una più precisa osservazione esige la Se vogliamo approfondire la nostra indagine sulla natura dovremo cominciare a valerci non solo dell’abito matematico ma anche della matematica come strumento: dovremo osservare la natura misurando quello che i sensi e il pensiero ci suggeriscono. Se avevamo associato il primo periodo al nome di Aristotele, potremo associare questo secondo periodo al nome di Leonardo da Vinci: «L’esperienza sui fenomeni naturali — dice Leonardo — va fatta misurando». Si troveranno rapporti, proporzioni, armonie nella natura, quelle stesse armonie che i Greci avevano trovato nell’arte. Così lo studio della botanica porterà alla scoperta della fillotassi, la zoologia e l’anatomia del corpo umano ci offriranno infiniti spunti e continuo terreno di ricerca. Al giudizio vago e personale si sostituiscono dei dati numerici, universali. Si va dunque avanti nell’arte di saper guardare; prima erano le somiglianze, le diversità, le forme, era il qualitativo, che ci faceva distinguere, discernere, scoprire gli invarianti; ora, in questo secondo periodo, il saper guardare vuol dire affinare i sensi con l’ausilio del numero: è il quantitativo che ci fa scoprire uguaglianze di rapporti, semplici leggi di proporzioni.

III) Ma la sola misura in un certo numero di casi non è spesso sufficiente per scoprire la legge. Dobbiamo arrivare al terzo stadio, al sistema ipotetico-deduttivo di Galilei per poter dare al ragazzo la consapevolezza della potenza dello strumento matematico allo scopo di riuscire a leggere nel «gran libro della natura».

Galileo si rivolge, come Leonardo, all’esperienza, ma non si accontenta di ciò che essa dà spontaneamente. La natura viene provocata, interrogata, idealizzata; si fanno delle ipotesi sui fenomeni che si rivelano ai sensi, si deducono da queste ipotesi delle conseguenze, si verifica con esperimenti se queste conseguenze sono esatte.

Anche a dei ragazzetti possiamo parlare del problema della caduta dei gravi: possiamo loro riferire dell’ipotesi di Galileo che la velocità sia proporzionale al tempo; è difficile verificare direttamente questa legge, ma, se vale questa legge se ne trae la conseguenza che gli spazi sono proporzionali ai quadrati dei tempi; e questa seconda legge è facile verificarla sperimentalmente. È vera allora l’ipotesi da cui eravamo partiti. Non è solo la potenza del procedimento ipotetico-deduttivo che il ragazzo coglie in un’esperienza di fisica molto meglio che in un ragionamento geometrico, ma egli comprende «sul vivo» la dinamicità di una formula, e questo è — a mio avviso — un risultato importantissimo. Le formule che noi presentiamo nel corso di matematica appaiono in generale come qualcosa di fisso, di statico; cogliere la dinamicità di una formula significa entrare in pieno nel concetto di funzione […].

IV) il quarto periodo infine è quello di Cartesio, è l’identificazione di algebra e geometria attraverso un saper guardare che porta l’attenzione non più sul particolare ente (sia esso numero o figura), ma sulle leggi formali che legano questi enti.

La cattedra di Scienze Matematiche, Chimiche, Fisiche e Naturali

Le proteste dei matematici però non rimasero inascoltate. La C.M. 10 luglio 1965, n. 292 consentirà ai Presidi di affidare a due docenti distinti, per ogni due corsi, l’insegnamento della Matematica e quello delle Osservazioni ed elementi di scienze naturali. In tal caso, ovviamente, il docente che avrebbe assunto quest’ultimo insegnamento doveva completare il suo orario di cattedra in una classe collaterale, effettuando così 16 o 17 ore settimanali, mentre l’altro docente, insegnando la sola matematica per 3 ore settimanali in ciascuna classe dei due corsi, avrebbe avuto un carico orario di 18 ore settimanali. La prospettata soluzione però non ebbe gran seguito; i docenti preferirono sempre di più l’impegno nelle sole tre classi di un corso mantenendo l’abbinamento dei due insegnamenti. Si arriva così dodici anni più tardi con la L. 348 del 16.6.1977 a sancire un insegnamento unitario che assume la denominazione di Scienze Matematiche, Chimiche, Fisiche e Naturali al posto di Matematica e Osservazioni ed Elementi di Scienze Naturali. Un insegnamento di matematica e di scienze integrate, finalizzato anche all’educazione sanitaria, che la legge potenzia portando la cattedra da 16 a 18 ore, 6 ore per classe senza altra distinzione interna. Saranno i programmi del 1979[5] a raccomandare di prevedere per ciascun anno una distribuzione equilibrata dei tempi da dedicare rispettivamente alla matematica e alle scienze sperimentali, e ciò perché, dati i frequenti collegamenti e la costante interazione prevista nel lavoro di classe fra la matematica e le scienze sperimentali, non è possibile stabilire una rigida ripartizione dell’orario settimanale fra le due aree.

Quei programmi del 1979 rappresentano il punto di arrivo e la meta qualitativa più elevata delle riflessioni sul rinnovamento pedagogico e didattico che aveva infervorato l’ultimo ventennio. Alla loro redazione lavorarono molti dei personaggi che quel dibattito avevano alimentato. realizzando un documento che ancora oggi si presenta il più completo e maturo e di armonica e coerente sintesi di pedagogia e scienza. Quei programmi, definiti anche tra i migliori d’Europa, rimasero, sia per l’organizzazione dei contenuti in grandi temi che per la modalità di scrittura e per i principi pedagogici, il riferimento per i programmi ministeriali che li seguirono, da quelli delle elementari del 1985 a quelli per il PNI e a quelli del progetto Brocca, cioè fino a quando ha avuto un senso parlare di programmi ministeriali.

La legge sull’autonomia scolastica (1997) infatti affiderà alle scuole il compito di costruire il programma di insegnamento, riservando al Ministero quello di definire gli obiettivi formativi cui i programmi delle scuole, tutte le scuole del territorio nazionale, devono tendere. Ai programmi ministeriali si sostituiscono così le Indicazioni Nazionali, ovvero gli standard di conoscenze e competenze che ogni scuola avrebbe dovuto perseguire. Un cambiamento la cui influenza sul piano pedagogico e didattico si palesa potenzialmente notevole.

Le prime Indicazioni Nazionali per il primo ciclo, primaria e secondaria di primo grado (non si chiama più scuola media), sono del 2004 legge Moratti). Esse non fanno più riferimento ad una cattedra di Scienze Matematiche, Chimiche, Fisiche e Naturali, ma contemplano l’insegnamento di Matematica e l’insegnamento di Scienze e Tecnologia. L’unitarietà degli insegnamenti così faticosamente raggiunta fu così rinnegata,[6] smembrata anche nel piano orario che su base annua assegnava mediamente 127 ore alla Matematica e 118 ore complessive a Scienze e Tecnologia, ovvero 85 per Scienze e 33 per Tecnologia[7]. Una separazione però durata poco, poco gradita a docenti, presidi e famiglie e all’amministrazione per le difficoltà di gestione delle cattedre (per legge di 18 ore), e gli stessi matematici sono ritornati sulle loro posizioni e hanno lasciato correre. Le attuali Indicazioni Nazionali, in vigore dal 1° settembre 2013, ricostituiscono l’unitarietà perduta: c’è un solo insegnamento, e non si chiama Scienze Matematiche, Chimiche, Fisiche e Naturali, ma ha la denominazione di Matematica e Scienze con sei ore settimanali indivise. Il problema però rimane: è quello dei docenti cui si chiede di possedere padronanza di un campo vastissimo di conoscenze e abilità non sorretto da opportunità formative adeguate.

I principi pedagogici e i contenuti dei programmi della scuola media del 1963 e del 1979

Già la premessa ai programmi del 1963 scandisce in chiare e precise raccomandazioni ai docenti quello che è il frutto migliore del pensiero pedagogico:

La continuità pedagogica (non occorre cominciare da zero): sarà […] necessario raccordarsi con l’insegnamento elementare utilizzando subito le nozioni che l’alunno già possiede (per esempio quelle sulle aree di particolari poligoni, sul sistema metrico decimale, ecc.).

L’ordine della trattazione: la ripartizione del programma nei tre anni di corso e l’ordine degli argomenti per ciascuno di essi non hanno valore vincolante. Ad esempio, già nella prima classe, accennando alle successive estensioni del concetto di numero, potrà essere anticipata la nozione di un numero relativo.

L’insegnamento a spirale: l’insegnante che in relazione allo sviluppo psicologico dell’alunno non abbia ritenuto di trattenersi a lungo sui capitoli più complessi, accontentandosi di una prima, sia pure approssimata, visione d’insieme, riprenderà in seguito i medesimi argomenti per un’analisi più approfondita al fine di un migliore svolgimento del programma.

Pedagogia dell’interesse, metodo genetico: nel passaggio dallo studio dei numeri interi a quello dei razionali e dei relativi, il professore potrà far cogliere agli alunni il processo storico e quello formale che hanno condotto alle successive estensioni del numero. Potrebbe anche essere utile dare un cenno, sotto la stessa luce, dei numeri irrazionali che si presentano con l’estrazione di radice quadrata.

Unità della matematica, fusionismo di de Finetti: sarà cura costante l’armonizzare l’aritmetica con la geometria.

Fusionismo in geometria: argomenti di geometria dello spazio potranno essere introdotti parallelamente ad altri riguardanti il piano, se una qualche analogia facilita la comprensione (quadrato e cubo…).

Visualizzazione, operatività: è consigliabile, ogni volta che se ne presenti l’occasione, il ricorso ai “grafici “, per la traduzione visiva che essi forniscono delle più varie circostanze, tenendo conto che l’insegnamento parallelo di osservazioni ed elementi di scienze naturali offrirà frequenti spunti per la rappresentazione grafica di relazioni.

La sistemazione e la riflessione su ciò che si sa, dal concreto all’astratto: nella terza classe si [….] porterà [….] l’alunno a ripensare e a riflettere sul programma svolto nelle tre classi al fine di far cogliere il senso e la necessità del passaggio da uno studio sperimentale e concreto a concezioni astratte e indagini razionali.

Pedagogia del controesempio: si terrà presente che una nozione può assumere un più chiaro significato se messa a raffronto con una nozione antitetica o parallela : così, per esempio, il sistema di numerazione decimale acquista tutto il suo valore ove lo si confronti con sistemi non posizionali o con sistemi a base diversa dal dieci ; e così, per mettere in risalto le proprietà formali delle operazioni, l’insegnante potrà portare esempi di leggi di composizione su insiemi numerici e non numerici, in cui tali proprietà vengano a mancare.

Metodo euristico, il valore dell’esercizio: l’esercizio non dovrà essere soltanto strumentale per il consolidamento della tecnica delle operazioni e dei procedimenti; esso deve essere inteso a fare gradualmente acquisire all’alunno il pieno possesso dei significati concettuali. Pertanto non ci si dovrà trattenere su complicati calcoli (espressioni aritmetiche laboriose; scomposizioni in fattori primi di numeri molto grandi; …).

Metodo attivo: alcune esercitazioni consisteranno in relazioni scritte e orali aventi il fine precipuo di fare esprimere all’alunno il proprio pensiero su elementari questioni matematiche derivanti da osservazioni spontanee e sopra le quali l’insegnante avrà chiamato la sua attenzione con suggerimenti, esperienze e ricorso a sussidi didattici (modelli, dispositivi, ecc.). Tali relazioni abitueranno l’alunno alla riflessione, alla correttezza e alla sobrietà di espressione.

Con chiarezza, sobrietà e concisione si esprime quasi tutto: dai metodi dell’insegnamento attivo, alla pedagogia del controesempio, al metodo bruneriano (ma già di Comenio) dell’approfondimento ciclico o a spirale, dal fusionismo ad un primo accenno di riferimento alla matematica moderna (le leggi di composizione), dal valore della prospettiva storica e dell’esercizio, all’invito a parlare e scrivere di matematica.

Non c’è nulla che non vada e tutto è talmente chiaro e comprensibile che ogni riflessione, ogni possibile miglioramento non può che andare proprio nella direzione di mirare a rafforzare quei principi pedagogici e ad esplicitare meglio taluni contenuti adeguandone anche il linguaggio ai nuovi tempi. È su questo che si discute nell’arco di un quindicennio[8]: si concorda che manca un riferimento esplicito alla matematica moderna e principalmente agli insiemi e alle strutture e ancora alla statistica e alla probabilità, alla matematizzazione del reale, alle tecnologie, e si ammette che va precisato meglio il previsto “ricorso ai grafici”, dunque alla geometria cartesiana. Infine va data una risposta alle questioni sull’ordine della trattazione: genetico, psico-genetico, per problemi, ecc.

I programmi del 1979 realizzano tutto ciò prevedendo sette “grandi temi” che mostrano già nei titoli ciò che dei contenuti si vuole rimarcare e rafforzare:

La geometria prima rappresentazione del mondo fisico

Insiemi numerici

Matematica del certo e matematica del probabile

Problemi ed equazioni

Il metodo delle coordinate.

Trasformazioni geometriche

Corrispondenze ed analogie strutturali.

Sul piano pedagogico le concezioni e i metodi già presenti nella premessa del ’63 trovano un loro completamento:

– nell’insegnamento dinamico della geometria: lo studio della geometria trarrà vantaggio da una presentazione non statica delle figure, che ne renda evidenti le proprietà nell’atto del loro modificarsi; […] La geometria dello spazio non sarà limitata a considerazioni su singole figure, ma dovrà altresì educare alla visione spaziale. È in questa concezione dinamica che va inteso anche il tema delle trasformazioni geometriche.

– nell’insegnamento per problemi: si terrà presente che risolvere un problema non significa soltanto applicare regole fisse a situazioni già schematizzate, ma vuol dire anche affrontare problemi allo stato grezzo[9] per cui si chiede all’allievo di farsi carico completo della traduzione in termini matematici.

Ad una didattica per problemi è direttamente connesso il riferimento esplicito alla matematizzazione intesa come interpretazione matematica della realtà nei suoi vari aspetti (naturali, tecnologici, economici, linguistici…) e particolare rilievo viene ancora dato alla interdisciplinarità e alla operatività: si farà ricorso ad osservazioni, esperimenti, problemi tratti da situazioni concrete così da motivare l’attività matematica della classe e si sottolineano i legami con la formazione della competenza linguistica, con l’educazione tecnica, con la geografia (metodo delle coordinate, geometria della sfera, …), con l’educazione artistica (prospettiva, simmetrie,…).

Per quanto riguarda gli argomenti, forte è il riferimento all’uso dei materiali[10], e raccomandate sono altresì le costruzioni con riga e compasso e l’uso ragionato degli strumenti di calcolo.

Dopo le accuse di insiemistificazione, il riferimento agli insiemi è posto in una formulazione saggia: il linguaggio degli insiemi potrà essere usato come strumento di chiarificazione, di visione unitaria e di valido aiuto per la formazione di concetti. Si eviterà comunque una trattazione teorica a sé stante, che sarebbe, a questo livello, inopportuna.

Una limitazione è poi inferta ad uno strumento antichissimo:

le proporzioni, che hanno sempre occupato un posto importante nell’insegnamento già dalle elementari con un legame privilegiato con la realtà e la risoluzione di problemi concreti. Ad esempio, nell’istituto magistrale (l’indirizzo di studio che ha preparato eserciti di maestri)[11] erano particolarmente importanti per le finalità educative e perché consentono di risolvere un’ampia classe di problemi di applicazione dell’algebra alla geometria in modo elementare, riconducendoli in genere ad equazioni di primo grado (noti il rapporto tra due grandezze e la loro somma o differenza o prodotto, o somma dei quadrati, ecc. ). Ad evitare esagerazioni, nei programmi del 1979 è scritto: l’argomento […] non deve essere appesantito imponendo, come nuove, regole che sono implicite nella proprietà delle operazioni aritmetiche, ma deve essere finalizzato alla scoperta delle leggi di proporzionalità (y = kx; xy = k).

Per quanto riguarda gli argomenti “nuovi”, il successo pieno spetta però alla geometria cartesiana:

il metodo delle coordinate con il rappresentare graficamente fenomeni e legami fra variabili, aiuterà a passare da un livello intuitivo ad uno più razionale. Alcune trasformazioni geometriche potranno essere considerate anche per questa via. E quella delle coordinate è una via che è divenuta quasi maestra nella pratica didattica a tutti i livelli di scolarità. Tant’è che nella prova scritta di matematica agli esami di licenza media la geometria analitica è apparsa sempre presente in almeno uno dei 3 o 4 quesiti in cui è articolata la prova[12]. Né la situazione sembra essere mutata in questi anni di disorientamento normativo: dalle prime Indicazioni Nazionali Moratti a quelle Fioroni e alla loro armonizzazione in vigore dal primo settembre del 2013.

Bruno de Finetti (1906-1985)

L’ordine e la struttura per temi

Una rilevanza decisamente maggiore assume poi l’attività di sistemazione e di riflessione su ciò che si è appreso, che trova una suo riferimento specifico soprattutto nel tema 7 ed è rimasta una costante nella didattica della matematica, tenuta particolarmente presente nella redazione dei successivi programmi. Dal punto di vista pedagogico è l’affermazione del convincimento che l’organizzazione dei contenuti matematici debba seguire la formazione dei concetti (Polya: concept formation) ed è la via da seguire per l’introduzione di un’assiomatica. Per la geometria, ad esempio, l’obiettivo da perseguire nella scuola superiore sarà di costruirne l’organizzazione invece di darla come cosa già bella e fatta, in una sua confezione tipo. La sistemazione logica dei contenuti è rinviata agli anni conclusivi del ciclo di studi secondari e ciò trova concretizzazione nei programmi per il PNI e nei piani di studi Brocca, come già detto precedentemente[13]. Si parte invece nei bienni con un lavoro propedeutico di organizzazione logica di piccole “parti”, un insieme ben definito di teoremi legati in una catena deduttiva che fa trasparire l’inferenza logica e prepara il campo alla comprensione del significato di un sistema deduttivo.

Sono però l’ordine della trattazione e la modalità della struttura per temi le caratteristiche che risaltano di più.

Mentre i programmi del 1963 sono ripartiti per anno e sembrano quasi contraddire quello che è detto nella bella premessa, quelli del 1979 rompono con gli itinerari standard e canonici, chiariscono che non c’è una sistemazione comoda della matematica, riferimento di una via didattica altrettanto comoda, e rimettono alla professionalità dei docenti la scelta del percorso più efficace: “Nel programma i contenuti sono raggruppati in temi e non elencati in ordine sequenziale, al fine di facilitare la individuazione di quelle idee che appaiono essenziali allo sviluppo del pensiero matematico degli allievi.” Il docente non deve ripercorrere nell’insegnamento quella che è stata la sua linea di apprendimento né avere a riferimento un ben definito ed esclusivo sviluppo del pensiero matematico, ma deve essere attento a farlo lievitare nei giovani, pronto e sensibile a manovrare concetti e procedure da saldare insieme trovandone sempre nuovi accostamenti. “I temi – è scritto – non devono essere quindi intesi come capitoli in successione, ma argomenti tratti da temi diversi potranno, in sede di programmazione, alternarsi ed integrarsi nell’itinerario didattico che l’insegnante riterrà più opportuno”.

La struttura per temi, come già più volte detto, è una modalità che ha avuto successo.

Presa a modello e utilizzata nei successivi documenti, ha tuttavia mostrato col tempo alcuni suoi limiti: per esempio, induce ad accrescere oltre il sostenibile l’ampiezza dei programmi a scapito della coerenza interna degli argomenti. Si parla dei programmi come di raccolte antologiche, di serbatoi enciclopedici. Si cerca di porvi riparo con la tendenza a voler essere più precisi, a dettagliare e ripartire gli argomenti, a corredarli di osservazioni, orientamenti, raccomandazioni e finanche di esempi di esercizi. È un segnale dell’impoverimento della riflessione nel settore della didattica matematica, che si registra tuttavia proprio quando i tempi sono maturi per l’affermazione di un’altra significativa novità, un’altra pietra miliare, e cioè il passaggio dai Programmi Ministeriali alle Indicazioni Nazionali della legge sull’autonomia scolastica (L. 59/1997 e D.P.R. n.275/99).

Esso stabilisce la dimensione individuale e personale del programma, che viene affidato alla singola istituzione scolastica e al singolo docente, mentre riserva all’Amministrazione della Scuola il compito di dettare, per l’intero territorio nazionale le mete, i traguardi di conoscenze ed abilità che lo studente deve possedere e la scuola deve aiutare a raggiungere e ad acquisire. A tali finalità avrebbero dovuto, per norma, corrispondere le Indicazioni Nazionali.

NOTE

[1] La facoltatività degli insegnamenti (reintrodotta dalla L.53/2003) fu eliminata nel 1977 con la legge n.348.

[2] È la prima esperienza di sperimentazione cui diede un impulso particolare il Ministro Giacinto Bosco. Nell’anno scolastico 1962/63 funzionavano 300 terze classi e 3 mila seconde classi sperimentali; il loro numero rappresentò un argomento decisivo con cui l’allora ministro Luigi Gui sollecitò il Parlamento all’approvazione della legge istitutiva.

[3] C. Motzo Dentice di Accadia, L’obbligo scolastico e la nuova scuola media, LSE, Napoli, 1965.

[4] «E quali non furono le sue preoccupazioni per la riforma della Scuola Media Inferiore! E quale fu il suo dolore per la battaglia.. … che lo vide perdente, contro l’abbinamento folle dell’insegnamento della Matematica alla Chimica, alla Fisica, alle Scienze Naturali nella Scuola Media unica?» da P. Dupont, Tullio Viola: Un esempio da imitare, Periodico di Matematiche 3/1986.

[5] Furono emanati con il D.M. 9 Febbraio 1979 del Ministro Pedini e pubblicati nel S.O. alla Gazzetta Ufficiale n.50 del 20 Febbraio 1979. Della commissione fecero parte i matematici: Giuseppe Arcidiacono, Luigi Campedelli, Emma Castelnuovo, Liliana Chini Artusi, Cesarina Dolfi, Michele Laforgia, Lucio Lombardo Radice, Giovanni Prodi, Francesco Speranza, Vinicio Villani.

[6] la battaglia per la separazione della cattedra, invece di affievolirsi è stata perseguita, in particolare dall’UMI, all’interno delle commissioni di studio costituite per l’elaborazione delle Indicazioni.

[7] Dall’anno scolastico 2006/07 portate a 66 ore.

[8] Le critiche non sono mancate. Significativa quella di Don Milani: “La seconda materia sbagliata è matematica. Per insegnarla alle elementari basta sapere quella delle elementari. Chi ha fatto la terza media ne ha tre anni di troppo [….] In quanto alla matematica superiore come parte della cultura generale si può provvedere in altro modo. Due o tre conferenze d’uno specialista che sappia dire a parole in che consiste […] Non è vero che occorra la laurea per insegnare matematica alle medie. È una bugia inventata dalla casta che ha i figlioli laureati. Ha messo la zampa su 20.478 posti di lavoro un po’ speciali. È la cattedra dove si lavora meno (16 ore settimanali) – È quella in cui non occorre aggiornarsi. Basta ripetere per anni le stesse cretinate che sa ogni bravo ragazzino di terza media. La correzione dei compiti si fa in un quarto d’ora. Quelli che non son giusti sono sbagliati” (da Lettera a una Professoressa, 1968)

[9] È un’espressione molto significativa, quasi trascurata però, per dire di problemi mancanti di qualche dato o da “raffinare” nelle richieste, che consentono anche una personalizzazione della formulazione.

[10] Le esperienze didattiche che E. Castelnuovo realizza già dagli anni ’50 sono diffusissime ed oggetto di “mostre” molto apprezzate. Diffusi sono anche, specie a livello primario, il materiale strutturato di Dienes, i regoli di Cuisinaire-Gattegno, quelli di Stern, i geopiani di Gattegno, le esperienze di Libois e di Papy (il minicomputer) e il materiale “povero” della pedagogia della Montessori.

[11] L’ultima maturità per i “maestri” c’è stata nel 1999 e con essa c’è stato l’ultimo problema per i maestri: una specialità tutta italiana di algebra applicata alla geometria e di legame con la realtà (cose che oggi si sbandierano senza conoscerne la storia).

[12] D.M. 26.8.1981: “La prova scritta di matematica deve tendere a verificare le capacità e abilità essenziali indicate dai programmi ministeriali, con riferimento ad un certo numero di argomenti scelti tra quelli maggiormente approfonditi nel triennio. A tal fine si darà una prova che dovrà riferirsi a più aree tematiche (fra quelle previste dai programmi) e a diversi tipi di conoscenze; la prova sarà articolata su tre o quattro quesiti, che non comportino soluzioni dipendenti l’una dall’altra. In tal modo si eviterà che la loro progressione blocchi l’esecuzione della prova stessa. Ad evitare una suddivisione troppo schematica dei contenuti, argomenti tratti da temi diversi potranno opportunamente coesistere nei singoli quesiti.

I quesiti potranno toccare sia aspetti numerici sia aspetti geometrici senza peraltro trascurare nozioni elementari nel campo della statistica e della probabilità. Uno dei quesiti riguarderà gli aspetti matematici di una situazione avente attinenza con attività svolte dagli allievi nel corso del triennio nel campo delle scienze sperimentali, dell’educazione tecnica o eventualmente di altri ambiti di esperienza.

Ogni commissione deciderà se e quali strumenti di calcolo potranno essere consentiti dandone preventiva comunicazione ai candidati. Durata della prova: tre ore.

[13] Didattica delle Scienze, n. 248, diretta da Mauro Laeng

L’articolo è in gran parte tratto da: Emilio Ambrisi, I 120 anni della Mathesis, Aracne 2015