Cattiva condotta scientifica in ambito umanistico

Nonostante sia meno discussa, la cattiva condotta in ambito umanistico è incentivata dagli stessi meccanismi che vigono per quello scientifico, e ormai comincia anche ad avvalersi degli stessi stratagemmi e a produrre un pari livello di inquinamento di quanto pubblicato

Ho partecipato ieri a una discussione molto interessante, tenutasi presso il Cnr, sul problema della sempre maggiore contaminazione della letteratura scientifica a causa di varie forme di cattiva condotta, che, grazie anche alle ultime tecnologie di intelligenza artificiale generativa, stanno producendo una montagna di carta straccia fatta passare per lavoro di ricerca.

Fra le questioni che sono state sollevate, una è ricorrente, ed è più o meno la seguente: considerato l’ampia disponibilità di informazioni sulla violazione dell’integrità scientifica nelle pubblicazioni del settore, cosa possiamo dire circa il settore umanistico? Qual è lo stato dell’arte, e vi è anche lì un impatto delle stesse pratiche fraudolente, oppure le materie prettamente umanistiche sono più al sicuro e meno appetite dai frodatori accademici e dalle compagnie che per denaro si propongono di assecondarne i bisogni?

Vorrei rimediare al fatto che ieri non ho avuto il tempo di fare qualche esempio, per proporne uno specifico, tratto dalle analisi che, insieme ad altri, sto conducendo sugli sviluppi più recenti.

L’intelligenza artificiale generativa, come è noto, è arrivata alla conoscenza del pubblico quando strumenti per ottenere testi più o meno elaborati e di livello più o meno buono sono stati messi a disposizione di tutti.

Inevitabilmente, questi strumenti possono essere usati anche per generare simulacri di articoli originali, che un autore può poi sottomettere per la pubblicazione, sperando che la cosa passi inosservata; e questo vale tanto per l’ambito scientifico che per quello umanistico. Anzi, per le materie umanistiche, in generale, la cosa può considerarsi tecnicamente più semplice, visto che si richiede solo un testo, ma non un insieme di dati coerenti con quello.

Per comprendere di cosa sto parlando, consideriamo una rivista di ambito prettamente umanistico, quale ad esempio quella denominata “International Journal for the Semiotics of Law – Revue internationale de Sémiotique juridique”. Si tratta di un giornale edito da Springer, e dunque non rientrante nel novero della cosiddetta “editoria predatoria”; una rivista cioè che dovrebbe avere uno standard qualitativo buono, e che, presumo, gode di un certo nome fra gli esperti umanisti del settore.

Il 17 dicembre 2023, tale rivista ha pubblicato un articolo intitolato “The Name is the Meaning: Language Used for the So-Called ‘MENA’”, firmato dalla dottoressa Patrizia Rinaldi dell’università di Granada.

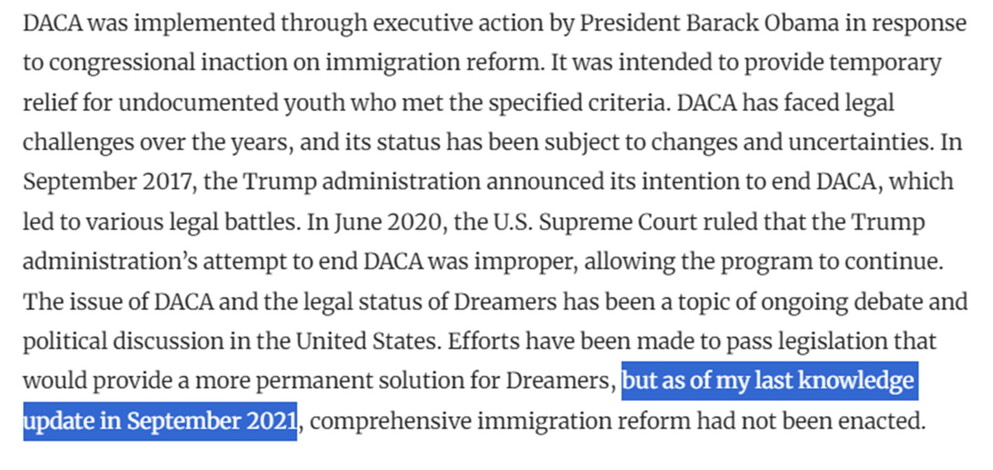

Nella quarta sezione di questo articolo, in chiusura, troviamo una frase piuttosto curiosa, che si conclude così: “but as of my last knowledge update in September 2021, comprehensive immigration reform had not been enacted.”

Questa, come sanno tutti quelli che hanno qualche familiarità con ChatGPT, è la tipica interiezione dovuta all’uso di uno strumento di intelligenza artificiale generativa, che, quando deve fornire informazioni circostanziate su un problema specifico, sottolinea lo stato di avanzamento del set di dati sul quale è stato effettuato l’addestramento. Un autore umano non scriverebbe mai un articolo a fine 2023, specificando di conoscere le cose solo fino a settembre 2021; la cosa appare quindi anche ridicola, se non fosse la spia evidente di quanto cerco di sostenere – cioè del fatto che se uno strumento è disponibile e vi è un incentivo al suo uso, la differenza fra settori scientifici e umanistici non è attesa.

Naturalmente, non si tratta di un caso unico; io ed altri nel mondo abbiamo individuato centinaia di articoli, anche di area umanistica e anche pubblicati su riviste prestigiose, per i quali è evidente l’uso di ChatGPT nella composizione del testo. Se e quanto siano state violate le regole di buona condotta e integrità, bisogna stabilirlo caso per caso, e non intendo sbilanciarmi in merito per quel che riguarda l’esempio qui discusso; sta di fatto, tuttavia, che l’uso di ChatGPT per generare manoscritti da sottoporre alle riviste scientifiche è equivalente in ogni area accademica, e sta di fatto che il plagio – una delle più diffuse forme di cattiva condotta in ambito umanistico – non potrà che essere rapidamente sostituito da comportamenti quali quello illustrato, considerato che i secondi, al contrario del primo, sono molto più difficilmente rilevabili.

Di fronte alla crisi costituita dall’emergere di un mercato di strumenti, aziende e individui che forniscono strumenti per rendere efficiente la produzione di falsi e più difficile la loro scoperta, non vi è porto sicuro; la ricerca di soluzioni riguarda per questo tutti, senza distinzioni settoriali e senza presunzioni di maggiore o minore “pulizia” di certe aree.

Continua la lettura su: https://www.ilfoglio.it/scienza/2024/04/19/news/cattiva-condotta-scientifica-in-ambito-umanistico-6459582/ Autore del post: Il Foglio Quotidiano Fonte: https://www.ilfoglio.it/